Rendimiento y grandes datos

Simplemente tener un equipo más rápido no es suficiente para garantizar el nivel adecuado de rendimiento para manejar grandes volúmenes de datos. ¡Tienes que ser capaz de distribuir los componentes de su servicio de datos grande a través de una serie de nodos. En computación distribuida, un nodo es un elemento de contenido dentro de un grupo de sistemas o dentro de un rack.

Un nodo típicamente incluye CPU, la memoria, y algún tipo de disco. Sin embargo, un nodo también puede ser una hoja de CPU y la memoria que se basan en las inmediaciones de almacenamiento dentro de un rack.

Dentro de un entorno de datos grande, estos nodos están normalmente agrupados juntos para proporcionar escala. Por ejemplo, usted podría comenzar con un análisis de datos grandes y continuar agregando más fuentes de datos. Para acomodar el crecimiento, una organización simplemente añade más nodos en un cluster para que pueda escalar para adaptarse a los requisitos de crecimiento.

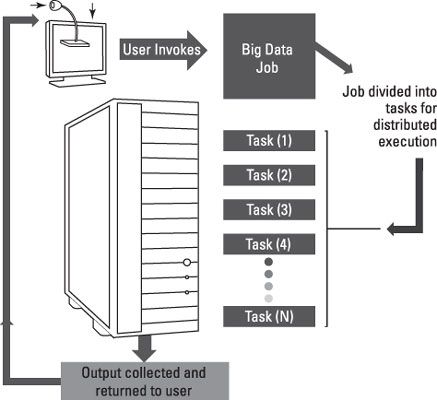

Sin embargo, no es suficiente simplemente ampliar el número de nodos en el cluster. Más bien, es importante ser capaz de enviar parte del análisis de datos grande para diferentes entornos físicos. Cuando usted envía estas tareas y la forma en que administra los hace la diferencia entre el éxito y el fracaso.

En algunas situaciones complejas, es posible que desee ejecutar muchos algoritmos diferentes en paralelo, incluso dentro del mismo grupo, para alcanzar la velocidad de análisis requerido. ¿Por qué ejecutar diferentes algoritmos de datos grandes en paralelo dentro del mismo rack? Cuanto más cerca estén las distribuciones de funciones son, más rápido se pueden ejecutar.

Aunque es posible distribuir el análisis de grandes datos a través de redes para aprovechar la capacidad disponible, usted debe hacer este tipo de distribución basado en requisitos de desempeño. En algunas situaciones, la velocidad de procesamiento tiene un asiento trasero. Sin embargo, en otras situaciones, obtener resultados rápido es el requisito. En esta situación, usted quiere asegurarse de que las funciones de red están muy cerca el uno al otro.

En general, el entorno de datos grande tiene que ser optimizado para el tipo de tarea de análisis. Por lo tanto, la escalabilidad es el eje central de la toma de datos de grandes operan con éxito. Aunque sería teóricamente posible operar un entorno de datos grande dentro de un solo entorno grande, no es práctico.

Para entender las necesidades de escalabilidad de datos grandes, uno sólo tiene que mirar a la escalabilidad nube y comprender tanto los requisitos y el enfoque. Al igual que la computación en nube, big data requiere la inclusión de redes rápidas y clusters de bajo costo de hardware que se pueden combinar de bastidores para aumentar el rendimiento. Estos grupos son apoyados por la automatización de software que permite escalamiento dinámico y equilibrio de carga.

El diseño y la implementación de MapReduce son excelentes ejemplos de cómo la computación distribuida puede hacer grandes datos operacionalmente visible y asequible. En esencia, las empresas se encuentran en uno de los puntos de inflexión únicos en computación donde los conceptos de tecnología se unen en el momento adecuado para resolver los problemas correctos. Combinando la computación distribuida, los sistemas de hardware mejoradas y soluciones prácticas como MapReduce y Hadoop está cambiando la gestión de datos de manera profunda.