La evolución de la computación distribuida para grandes datos

Detrás de todas las tendencias importantes en la última década, incluyendo la orientación al servicio, la computación en nube, virtualización y big data, es una tecnología fundamental llamada computación distribuida.

En pocas palabras, sin distribuir la computación, ninguno de estos avances sería posible.La computación distribuida es una técnica que permite a los ordenadores individuales sean conectados en red a través de áreas geográficas como si fueran un único entorno. Usted encontrará muchas implementaciones diferentes de la computación distribuida. En algunas topologías, las entidades individuales computing simplemente pasan mensajes entre sí.

En otras situaciones, un entorno informático distribuido podrá compartir recursos que van desde la memoria a las redes y almacenamiento. Todos los modelos de computación distribuida tienen un atributo común: Son un grupo de ordenadores en red que trabajan juntos para ejecutar una carga de trabajo o proceso.

DARPA y datos grande

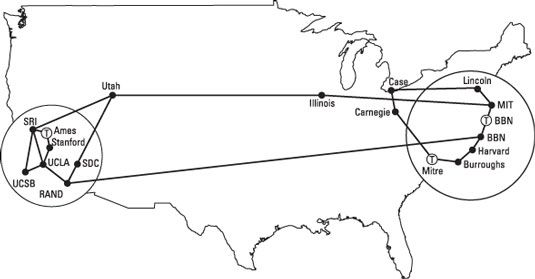

El modelo de computación distribuida más conocida, la Internet, es la base de todo, desde el comercio electrónico para la computación en nube para la gestión del servicio y la virtualización. El Internet fue concebido como un proyecto de investigación financiado por los EE.UU. DARPA.

Fue diseñado para crear un sistema de redes de interconexión que apoyaría no comercial, colabore investigación entre los científicos. En los primeros días de la Internet, estos equipos a menudo se conectan mediante líneas telefónicas! A menos que usted experimentó esa frustración, sólo se puede imaginar lo lentos y frágiles esas conexiones eran.

A medida que la tecnología maduró durante la próxima década, los protocolos comunes como Transmission Control Protocol (TCP) ayudaron a proliferar la tecnología y la red. Cuando se añadió el Protocolo de Internet (IP), el proyecto pasó de una red cerrada para una colección de científicos a una plataforma potencialmente comercial para transferir el correo electrónico en todo el mundo.

A lo largo de la década de 1980, los servicios nuevos basados en Internet comenzaron a surgir en el mercado como una alternativa comercial a la red DARPA. En 1992, el Congreso de Estados Unidos aprobó la Ley de Ciencia y Tecnología Avanzada-que, por primera vez, permite un uso comercial de esta poderosa tecnología de redes. Con continuado su crecimiento explosivo, Internet es realmente una red distribuida mundial y sigue siendo el mejor ejemplo del poder de la computación distribuida.

El valor de un modelo de datos de gran coherente

¿Qué diferencia este esfuerzo liderado por DARPA crea en el movimiento para la computación distribuida? Antes de la comercialización del Internet, había cientos de empresas y organizaciones que crean una infraestructura de software destinado a proporcionar una plataforma común para apoyar un entorno de computación altamente distribuida.

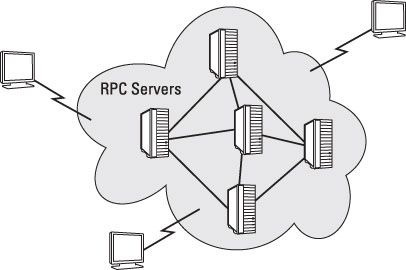

Sin embargo, cada proveedor o estándares de la organización surgió con sus propias llamadas de procedimientos remotos (RPC) que todos los clientes, desarrolladores de software comercial, y socios tendrían que adoptar y apoyo. RPC es un mecanismo primitivo utilizado para enviar el trabajo a un equipo remoto y por lo general requiere de espera para el trabajo a distancia para completar antes puede continuar otros trabajos.

Con los proveedores de ejecución de RPC de propiedad, se hizo impracticable imaginar que cualquier empresa sería capaz de crear un estándar universal para la computación distribuida. A mediados de la década de 1990, los protocolos de Internet reemplazan estos planteamientos primitivos y se convirtieron en la base para lo que está distribuida la computación hoy en día. Después de esto se resolvió, los usos de este enfoque de la computación en red comenzaron a florecer.