Operando flujos de trabajo oozie en hadoop

Antes de ejecutar los flujos de trabajo oozie, todos sus componentes tienen que existir dentro de una estructura de directorio especificado. En concreto, el flujo de trabajo en sí debe tener su propio directorio, dedicado, donde workflow.xml está en el directorio raíz, y existen bibliotecas de código en el subdirectorio llamado lib. El directorio de flujo de trabajo y todos sus archivos deben existir en HDFS para que pueda ser ejecutado.

Si usted va a utilizar la interfaz de línea de comandos Oozie para trabajar con varios puestos de trabajo, asegúrese de establecer la variable de entorno OOZIE_URL. (Esto se hace fácilmente desde una línea de comandos en un terminal de Linux.) Usted puede ahorrar un montón de escribir debido a la URL del servidor Oozie ahora automáticamente se incluye con sus peticiones.

Aquí hay un comando de ejemplo se podría utilizar para establecer la variable de entorno OOZIE_URL desde la línea de comandos:

exportación OOZIE_URL = "http: // localhost: 8080 / oozie"

Para ejecutar una carga de trabajo Oozie desde la interfaz de línea de comandos Oozie, ejecute un comando como el siguiente, garantizando al mismo tiempo que el archivo es job.properties localmente accesible - significa la cuenta que está utilizando se puede ver, lo que significa que tiene que estar en el mismo sistema en el que se está ejecutando Oozie comandos:

$ Job oozie -config sampleWorkload / job.properties -run

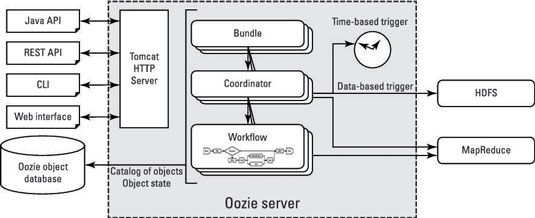

Después de enviar un trabajo, la carga de trabajo se almacena en la base de datos de objetos Oozie.

En la presentación, Oozie devuelve un identificador para que pueda monitorear y administrar el flujo de trabajo - empleo: 0000001 hasta 00000001234567-oozie-W, por ejemplo.

Para comprobar el estado de este trabajo, usted ejecuta el comando

trabajo oozie -info 0000001-00000001234567-oozie-W