Errores de nodo y disco esclavo en HDFS

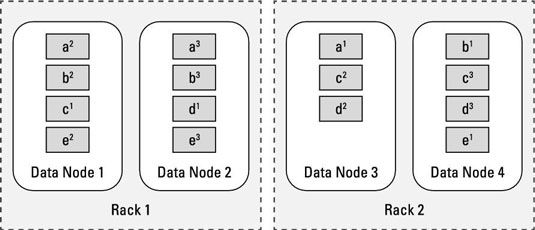

Al igual que la muerte y los impuestos, fallos de disco (y dado el tiempo suficiente, incluso errores de nodo o bastidor), son inevitables en Hadoop Distributed File System (HDFS). En el ejemplo mostrado, incluso si un rack fallara, el grupo podría continuar su funcionamiento. Rendimiento sufriría porque ha perdido la mitad de sus recursos de procesamiento, pero el sistema está todavía en línea y todos los datos son todavía disponibles.

En un escenario en el que falla una unidad de disco o un nodo esclavo, el servidor de metadatos central para HDFS (llamado NameNode) finalmente encuentra que los bloques del archivo almacenados en el recurso fallado ya no están disponibles. Por ejemplo, si Slave Nodo 3 falla, esto significaría que los bloques A, C, y D son underreplicated.

En otras palabras, muy pocas copias de estos bloques están disponibles en HDFS. Cuando HDFS detecta que un bloque se underreplicated, ordena una nueva copia.

Para continuar con el ejemplo, decir que nodo Esclavo 3 viene de nuevo en línea después de unas horas. Mientras tanto, HDFS ha asegurado que hay tres copias de todos los bloques del archivo. Así que ahora, los bloques A, C, y D tienen cuatro copias cada uno y son overreplicated. Al igual que con los bloques underreplicated, el servidor de metadatos central de HDFS se enterará de esto también, y ordenará una copia de todos los archivos que desea eliminar.

Un buen resultado de la disponibilidad de los datos es que cuando se producen fallos de disco, no hay necesidad de sustituir inmediatamente los discos duros que han fallado. Esta forma más eficaz se puede hacer en intervalos regulares.