Ejecución de aplicaciones antes hadoop 2

Debido a que muchos despliegues de Hadoop existentes todavía no están utilizando embargo, otro negociador de recursos (HILO), tomar un rápido vistazo a cómo Hadoop logró su procesamiento de datos antes de los días de Hadoop 2. Concéntrese en el papel que los demonios maestros JobTracker y demonios esclavos TaskTracker jugaron en el manejo de procesamiento MapReduce.

El punto de emplear sistemas distribuidos es ser capaz de desplegar los recursos informáticos en una red de ordenadores autónomos de una manera que es tolerante a fallos, fácil, y barato.

En un sistema distribuido, como Hadoop, donde se tiene un grupo de nodos de computación auto-contenida todos trabajando en paralelo, una gran cantidad de complejidad va en asegurar que todas las piezas funcionan juntos. Como tal, estos sistemas tienen típicamente capas distintas para manejar diferentes tareas para apoyar el procesamiento de datos en paralelo.

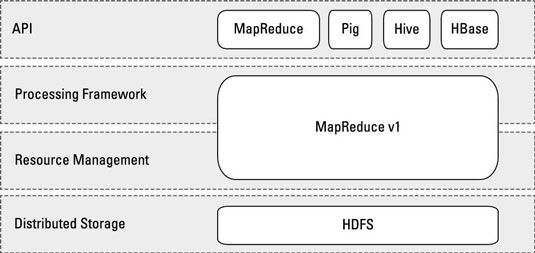

Este concepto, conocido como el separación de intereses, asegura que si usted es, por ejemplo, el programador de la aplicación, usted no tiene que preocuparse por los detalles específicos para, por ejemplo, la conmutación por error de tareas mapa. En Hadoop, el sistema consta de estos cuatro capas distintas, como se muestra:

Almacenamiento distribuido: El sistema de archivos distribuido Hadoop (HDFS) es la capa de almacenamiento donde se almacenan los datos, los resultados provisionales, y los conjuntos de resultados finales.

Administracion de recursos: Además de espacio en disco, todos los nodos esclavos del clúster Hadoop tienen ciclos de CPU, RAM, y ancho de banda de la red. Un sistema como Hadoop tiene que ser capaz de repartir estos recursos para que múltiples aplicaciones y los usuarios pueden compartir el cluster de forma predecible y ajustables. Este trabajo está hecho por el demonio JobTracker.

Marco de procesamiento: El flujo del proceso MapReduce define la ejecución de todas las aplicaciones en Hadoop 1. Esto comienza con el mapa de fase continua con la agregación con shuffle, el género, o merge- y termina con la fase de reducir. En Hadoop 1, esto también es administrada por el demonio JobTracker, con ejecución local siendo gestionado por demonios TaskTracker que se ejecutan en los nodos esclavos.

Application Programming Interface (API): Las aplicaciones desarrolladas para Hadoop 1 necesitaban ser codificado utilizando la API de MapReduce. En Hadoop 1, los proyectos de la colmena y cerdo proporcionan programadores con interfaces más fáciles para escribir aplicaciones de Hadoop, y debajo de la campana, su código compila hasta MapReduce.

En el mundo de Hadoop 1 (que era el único mundo que tenía hasta hace muy poco), todo el procesamiento de datos girado en torno MapReduce.